Data Quality : enjeux, critères de qualité, processus et outils

Dernière mise à jour le : 18 Avr 2024

La Data Quality, ou qualité des données en français, fait battre le cœur de votre stratégie de commercialisation de produits. L’avènement du Cloud et la profusion du Big Data soulèvent en effet des problèmes de gestion de la qualité des données au sein de toutes les entreprises : retail, grande distribution, e-commerce…

Si vos critères d’évaluation de la qualité des données sont biaisés, chaque mauvaise décision risque de vous coûter cher. Cet article met en lumière toute l’intelligence portée par la donnée, les indicateurs de mesure essentiels, les outils tels que le Master Data Management et les process à adopter pour mettre en place une démarche de Data Quality Management qui sert réellement vos objectifs business.

Data Quality et enjeux business pour les entreprises

15 millions de dollars de pertes par an : voici le coût moyen d’une mauvaise gestion de la qualité des données, révélé par l’enquête du cabinet Gartner. L’étude en question met en lumière la corrélation directe entre l’absence de démarche de Data Quality et le nombre d’opportunités commerciales manquées.

Il apparaît donc logique que 40 % des acheteurs retournent un produit en raison d’informations insuffisantes sur le produit. Cette insuffisance de données s’explique par la présence d’erreurs, d’informations inexactes, incomplètes, obsolètes, ou encore incohérentes et parfois dupliquées concernant le produit.

Consciente des enjeux de gouvernance des données, l’enseigne Decathlon a notamment mis en place sa propre stratégie de Data Quality. La responsable de la qualité des données cite un exemple parlant dans la vidéo suivante : le contrôle de la qualité des données liées au Click and Collect permet de prédire le nombre de cartons à prévoir et de colis qui vont être récupérés. Ce cas d’usage concret illustre toute l’intelligence portée par la gestion de la qualité des données : la Data Quality constitue un levier de compétitivité et de satisfaction client puissant.

Vidéo « La qualité des données : un enjeu de la data gouvernance chez Décathlon » :

À l’inverse, les problèmes engendrés par une mauvaise qualité des données produits se traduisent en conséquences négatives pour toute l’organisation. L’expérience omnicanale devient insuffisante ou complètement ratée pour les acheteurs, entraînant une détérioration de l’image de marque et de la satisfaction client. Les avis clients et la réputation d’une enseigne peuvent vite se dégrader.

Les acheteurs déçus favorisent également l’augmentation des retours produits et des invendus. Une organisation peut par ailleurs subir des sanctions légales si elle n’affiche pas les mentions obligatoires. L’ensemble des actions marketing deviennent alors inefficaces. Les pertes de productivité au sein des équipes qui doivent gérer et diffuser les données produits engendrent mathématiquement des coûts opérationnels qui impactent toute l’organisation.

Si le consommateur est exposé à tous ces manquements, c’est que les responsables marketing, e-commerce ou encore achats, ne disposent pas d’une plateforme dédiée, capable de leur offrir un accès structuré à une qualité de données orientée commercialisation.

Nous vous présentons les outils performants en fin d’article. Abordons tout d’abord à partir de quels critères évaluer la qualité des données.

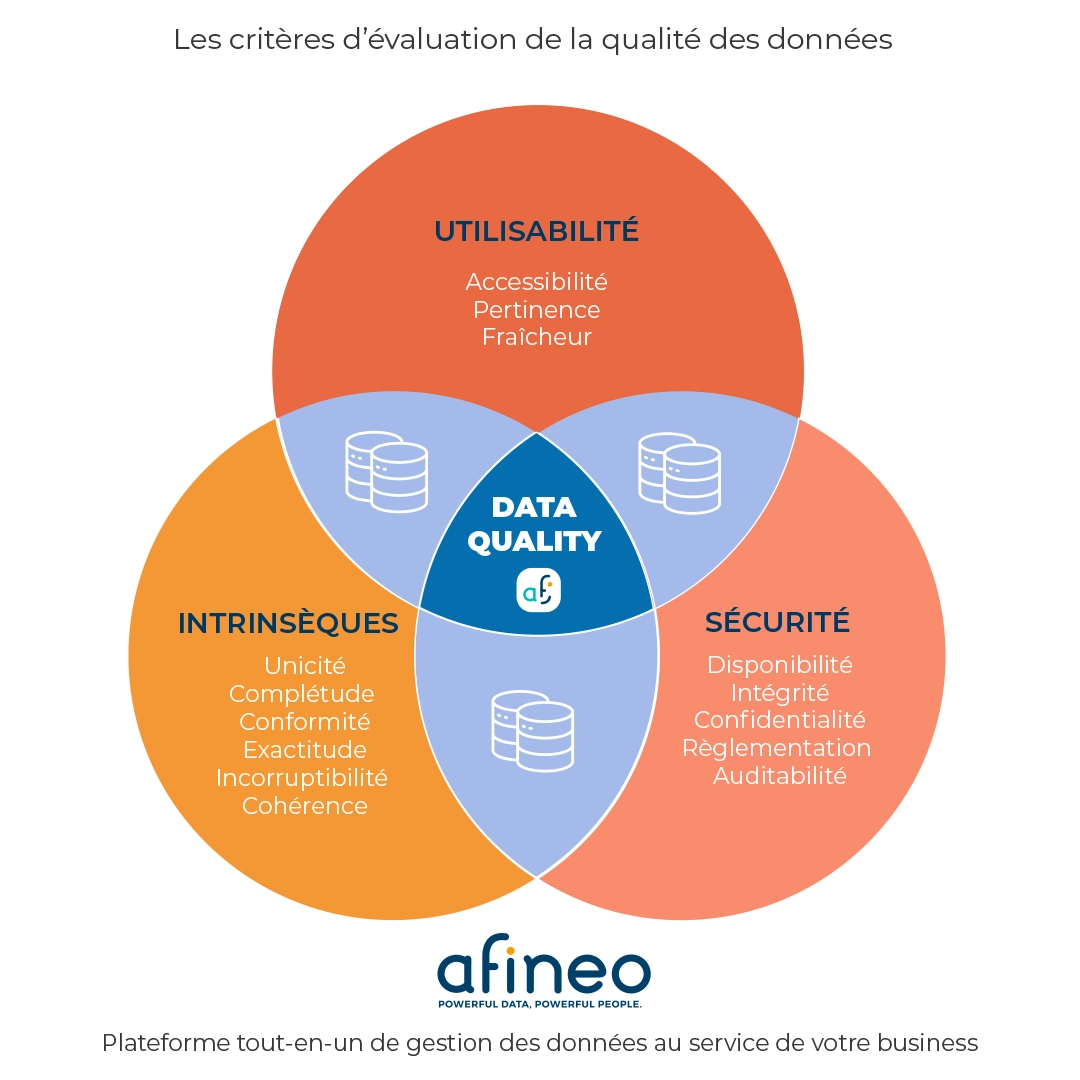

Les critères d’évaluation de la qualité des données

L’évaluation de la qualité des données ou Data Quality Assessment repose sur l’observation du respect de plusieurs caractéristiques aussi appelées dimensions.

Observons d’abord les critères principaux d’évaluation de la qualité des données à travers un schéma puis détaillons-les.

Critères intrinsèques aux données

- Unicité : l’utilisateur ne doit pas pouvoir confondre deux informations ni deux produits. Un identifiant unique pour chacun et une vérification des doublons sont incontournables.

- Exhaustivité ou complétude : les données ne doivent pas comporter de champs manquants. Il faut notamment vérifier les attributs spécifiques essentiels à la catégorisation (taille, couleur, ..), mais également aux étapes d’analyse.

- Conformité aux conventions de l’entreprise : le cadre d’utilisation des données doit être défini selon des règles de nommage et de formats de données afin d’éviter des valeurs inexactes et des formats inutilisables.

- Exactitude ou précision : chaque donnée doit être correcte et correspondre à la réalité, mais également précise, selon une nomenclature spécifique définie en amont.

- Incorruptibilité : la donnée ne doit pas être altérée après utilisation, que ce soit par un utilisateur, par une mauvaise configuration d’une liaison avec un objet associé à la donnée, ou encore lors d’échanges entre deux systèmes d’information.

- Cohérence : vos données doivent respecter une certaine logique entre elles et ne pas entrer en conflit en présentant par exemple des informations contradictoires (exemple : une gamme de pulls en laine dont un produit serait renseigné en 100% synthétique).

Critères garantissant l’utilisabilité

- Accessibilité : les équipes métiers doivent pouvoir facilement trouver les données dont ils ont besoin pour effectuer leurs missions. La classification et les capacités d’un outil de gestion des données sont primordiales pour garantir l’efficience des entreprises.

- Pertinence : les équipes produit, achat, marketing, e-commerce (…) doivent disposer d’informations utiles pour exécuter leurs missions respectives avec efficacité au sein de leurs processus. Les données doivent correspondre à des usages métiers.

- Actualité ou fraîcheur : dans un contexte de commercialisation de produits, il est impératif de maintenir à jour sa base de données produits afin d’y incorporer les nouvelles gammes, les nouvelles contraintes réglementaires (exemple : loi Agec), et les critères relatifs à la saisonnalité des ventes notamment.

Critères préservant la sécurité

- Disponibilité : différentes mesures doivent préserver l’accès aux données, telles que

la protection, la capacité et la traçabilité. Trois grands principes à appliquer aux outils de gestion des données, à l’hébergement et au réseau informatique. - Intégrité : les droits d’accès utilisateurs doivent pouvoir être réglés comme du papier à musique afin de permettre la modification de certaines données aux seules équipes concernées. L’historisation des évènements relatifs au traitement des données et le versionning permettent également d’identifier d’éventuelles anomalies et de corriger le tir de manière réactive.

- Confidentialité : cette dimension concerne les niveaux d’habilitation accordés aux utilisateurs, ainsi qu’aux partenaires commerciaux externes à l’entreprise.

- Règlementation : les contraintes légales imposent un traitement spécifique des données personnelles ou sensibles (RGPD), mais également un devoir d’information et d’affichage pour renseigner le consommateur (loi Agec).

- Auditabilité : des mesures doivent être mises en place pour lutter contre la perte et la fuite de données, mais également pour analyser régulièrement le niveau de qualité des données.

Les 6 processus d’une démarche de Data Quality Management efficiente

La mise en place d’une démarche de Data Quality Management – ou de gestion de la qualité des données en français – s’articule en six processus.

Tout Data Quality Manager ou Data Steward digne de ce nom respecte le traitement de ces processus par étape en gardant en tête les objectifs de l’organisation.

Ces responsables de la gestion de la qualité des données de l’entreprise s’inscrivent par ailleurs dans une approche d’amélioration continue : les données et les missions des utilisateurs évoluent en effet dans le temps !

| Processus | Objectifs |

|---|---|

| 1. Profilage |

|

| 2. Homogénéisation |

|

| 3. Nettoyage |

|

| 4. Dédoublonnage |

|

| 5. Enrichissement |

|

| 6. Contrôle |

|

Les outils pour garantir la qualité des données dans une optique marketing

La plateforme SaaS Afineo rassemble tous les modules et fonctionnalités nécessaires afin de contrôler, d’évaluer la qualité des données, d’effectuer un nettoyage des données, mais également de gérer l’ensemble de leur chaîne de valeur jusqu’à leur diffusion sur les canaux de vente sans erreurs, tout en facilitant les missions des équipes métiers. Examinons les principaux outils de notre plateforme de Data Management et de Media Management et leurs avantages.

Le PIM (Product Information Management) permet de constituer un référentiel unique relatif à la gestion des informations produits. Les informations des articles commercialisés éparpillés dans différents systèmes ou fichiers sont importées, traitées et enrichies afin d’unifier la qualité des informations.

Sur un principe similaire, le DAM (Digital Asset Management) permet de constituer un référentiel unique relatif à la gestion des données produits, plus précisément les assets digitaux tels que les fichiers images, visuels produits, logos, vidéos, audio, et autres formats comme les notices par exemple.

L’association du PIM et du DAM permet de diffuser l’ensemble des informations et assets sur les différents canaux de vente de manière pertinente sans aucun oubli : les mentions légales/obligatoires, descriptifs, visuels standardisés, offres personnalisées et limitées dans le temps (etc.). La cohérence des données est respectée sur les canaux : e-commerce (fiche produit), marketplace, kit de balisage magasin, catalogue imprimé, borne interactive, tablette vendeur par exemple. Vous respectez vos obligations légales, tout en répondant aux attentes des acheteurs sur la transparence et la complétude des informations.

Data Quality et MDM sont souvent associés : une solution de Master Data Management permet en effet de structurer plusieurs référentiels de données. On parle alors de gestion des données de références, ou « données maîtres ». Un MDM permet ainsi de mettre en place des référentiels supplémentaires tels qu’un portail B2B consacré à récolter les données de ses fournisseurs par exemple. MDM et PIM sont souvent confondus, pourtant la différence est limpide !

« La qualité des données est maintenue grâce à des sources uniques de vérité accessibles aux utilisateurs métiers au sein d’une même plateforme. »

Ceci rassure le DSI qui s’économise les contraintes d’interfaçages entre un système d’information et plusieurs logiciels, et les problèmes de productivité liés.

Le terme Data Quality révèle par ailleurs tout son sens lorsqu’il s’agit de l’utiliser comme un outil décisionnel orienté business ! Parlons-en : le module Performance Produit & Opérations Commerciales d’Afineo couplé au PIM offre d’observer les performances de ventes en tenant compte de la saisonnalité pour constituer la sélection de produit idéale dans une optique commerciale… dont la rentabilité est estimée à l’avance ! La gestion des stocks est optimisée et la réduction des invendus au rendez-vous.

Imaginez vos possibilités : récolter les avis clients pour vous en servir comme argument de vente « réassurant », analyser la fréquentation mensuelle ou journalière de chacun de vos points de vente, les performances par produit/saison/adhérent, ou encore analyser l’efficacité d’une opération promotionnelle …

Vous voulez obtenir une qualité de données qui stimule vos réussites commerciales ? Demandez une démonstration de la plateforme Afineo : nous vous montrerons les performances concrètes que les différents outils peuvent vous procurer !